Datenschutz im Smart Home: So schützt du deine Daten

Smart Homes versprechen Komfort, Effizienz und ein vernetztes Leben. Doch mit all den intelligenten Geräten, die unseren Alltag erleichtern, stellt sich eine immer wichtigere Frage: Was passiert mit unseren Daten? Der Schutz deiner Privatsphäre im eigenen Zuhause ist kein Luxus, sondern eine Notwendigkeit. In diesem Beitrag tauchen wir tief in die Welt des Datenschutzes im Smart Home ein und zeigen dir, wie du deine persönlichen Informationen effektiv schützen kannst.

Gibt es überhaupt personenbezogene Daten im Smart Home?

Die klare Antwort lautet: Ja, definitiv! Auch wenn du dir vielleicht nicht bewusst bist, welche Informationen deine Smart-Home-Geräte sammeln, sind sie oft weitreichender, als du denkst.

- Bewegungsdaten: Sensoren registrieren, wann und wo du dich in deinem Zuhause bewegst. Das kann Rückschlüsse auf Anwesenheit und Gewohnheiten zulassen.

- Sprachaufnahmen: Sprachassistenten wie Alexa oder Google Assistant zeichnen deine Befehle auf, die oft auch persönliche Gespräche im Hintergrund beinhalten können.

- Videodaten: Überwachungskameras, smarte Türklingeln oder Babyphones erfassen kontinuierlich Bilder und Videos, die Gesichter, Aktivitäten und Umgebungen zeigen.

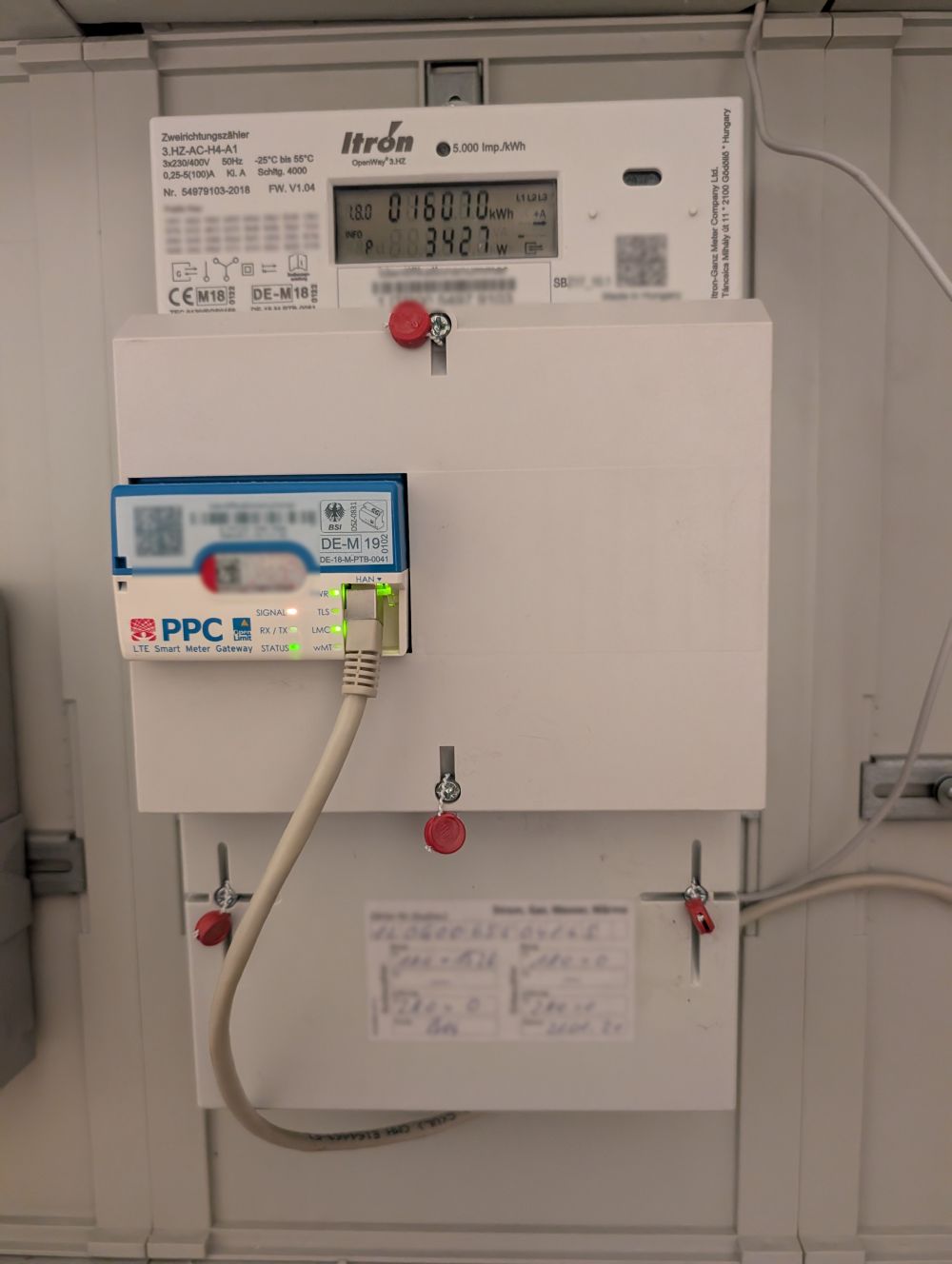

- Energieverbrauchsdaten: Intelligente Thermostate oder Steckdosen protokollieren deinen Stromverbrauch, was wiederum Rückschlüsse auf deine Lebensweise ermöglicht.

- Gesundheitsdaten: Smarte Waagen, Fitness-Tracker oder Schlafsensoren sammeln hochsensible Gesundheitsinformationen.

- Standortdaten: Viele Geräte benötigen Standortzugriff, um wetterbasierte Automatisierungen oder Geofencing-Funktionen zu ermöglichen.

All diese Informationen können, einzeln oder in Kombination, sehr persönliche Einblicke in dein Leben geben.

Auf was ist bei der Privatsphäre zu achten?

Deine Privatsphäre im Smart Home zu wahren, erfordert Aufmerksamkeit und proaktives Handeln. Hier sind die wichtigsten Punkte, auf die du achten solltest:

- Berechtigungen prüfen: Bevor du eine neue App für dein Smart-Home-Gerät installierst, wirf einen genauen Blick auf die angeforderten Berechtigungen. Benötigt die smarte Lampe wirklich Zugriff auf dein Mikrofon oder deine Kontakte?

- Datenschutzerklärungen lesen: Auch wenn es mühsam ist, versuche, die Datenschutzerklärungen der Hersteller zu überfliegen. Hier erfährst du, welche Daten gesammelt werden, wie sie verarbeitet und ob sie an Dritte weitergegeben werden.

- Standardeinstellungen anpassen: Viele Geräte sind mit den liberalsten Datenschutzeinstellungen vorkonfiguriert. Ändere diese unbedingt und deaktiviere Funktionen, die du nicht benötigst, wie zum Beispiel permanente Sprachaufzeichnungen.

- Standortfreigabe überdenken: Überlege, ob jedes Gerät deinen genauen Standort kennen muss. Oft reichen grobe Standortdaten oder die manuelle Eingabe deiner Adresse.

- Gastzugänge einschränken: Wenn du Freunden Zugang zu deinem Smart Home gewährst, stelle sicher, dass sie nur auf die wirklich notwendigen Funktionen zugreifen können und keine umfassenden Daten einsehen können.

Was sind Risiken?

Die Missachtung des Datenschutzes im Smart Home birgt verschiedene Risiken:

- Cyberangriffe: Ungesicherte Geräte sind Einfallstore für Hacker. Sie könnten Zugriff auf deine Kameras erlangen, deine Sprachaufnahmen abhören oder sogar dein gesamtes Netzwerk kompromittieren.

- Datendiebstahl: Deine gesammelten Daten könnten gestohlen und auf dem Schwarzmarkt verkauft werden. Diese Informationen können für Identitätsdiebstahl, gezielte Werbung oder sogar Erpressung genutzt werden.

- Profilbildung: Unternehmen können umfassende Profile über dein Verhalten, deine Gewohnheiten und Vorlieben erstellen. Diese Profile werden dann für personalisierte Werbung oder zur Vorhersage von Konsummuster verwendet.

- Überwachung: Im schlimmsten Fall könnten Dritte (z.B. Geheimdienste oder Kriminelle) dein Zuhause überwachen, um Informationen über dich zu sammeln.

- Offenlegung sensibler Informationen: Gesundheitsdaten, Finanzinformationen oder intime Details deines Privatlebens könnten durch unsichere Smart-Home-Systeme unfreiwillig offengelegt werden.

Was wären Empfehlungen?

Um deine Daten im Smart Home effektiv zu schützen, empfehle ich dir folgende Maßnahmen:

- Sichere Passwörter verwenden: Das ist das A und O! Nutze lange, komplexe Passwörter für alle deine Smart-Home-Geräte und dein WLAN. Verwende niemals Standardpasswörter.

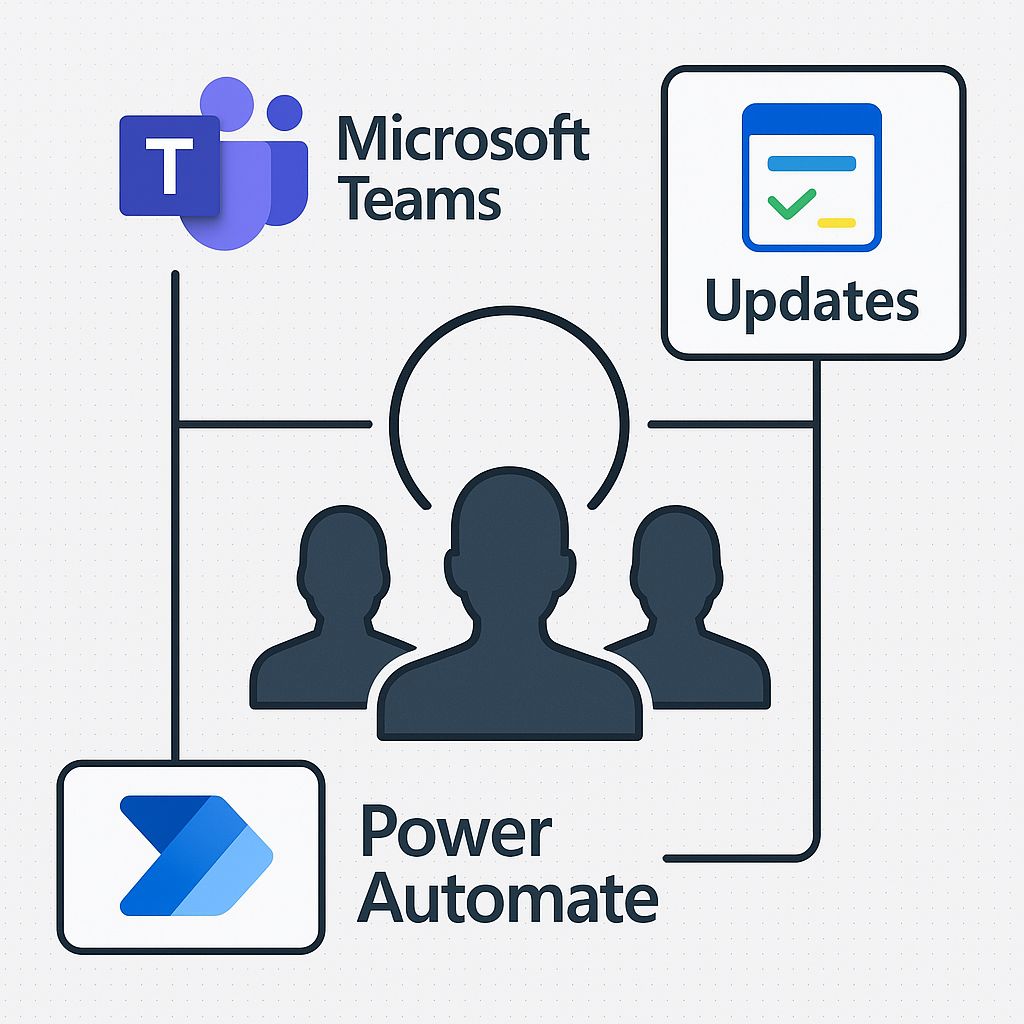

- Regelmäßige Updates: Halte die Firmware und Software deiner Smart-Home-Geräte sowie deiner Apps stets aktuell. Updates schließen oft Sicherheitslücken.

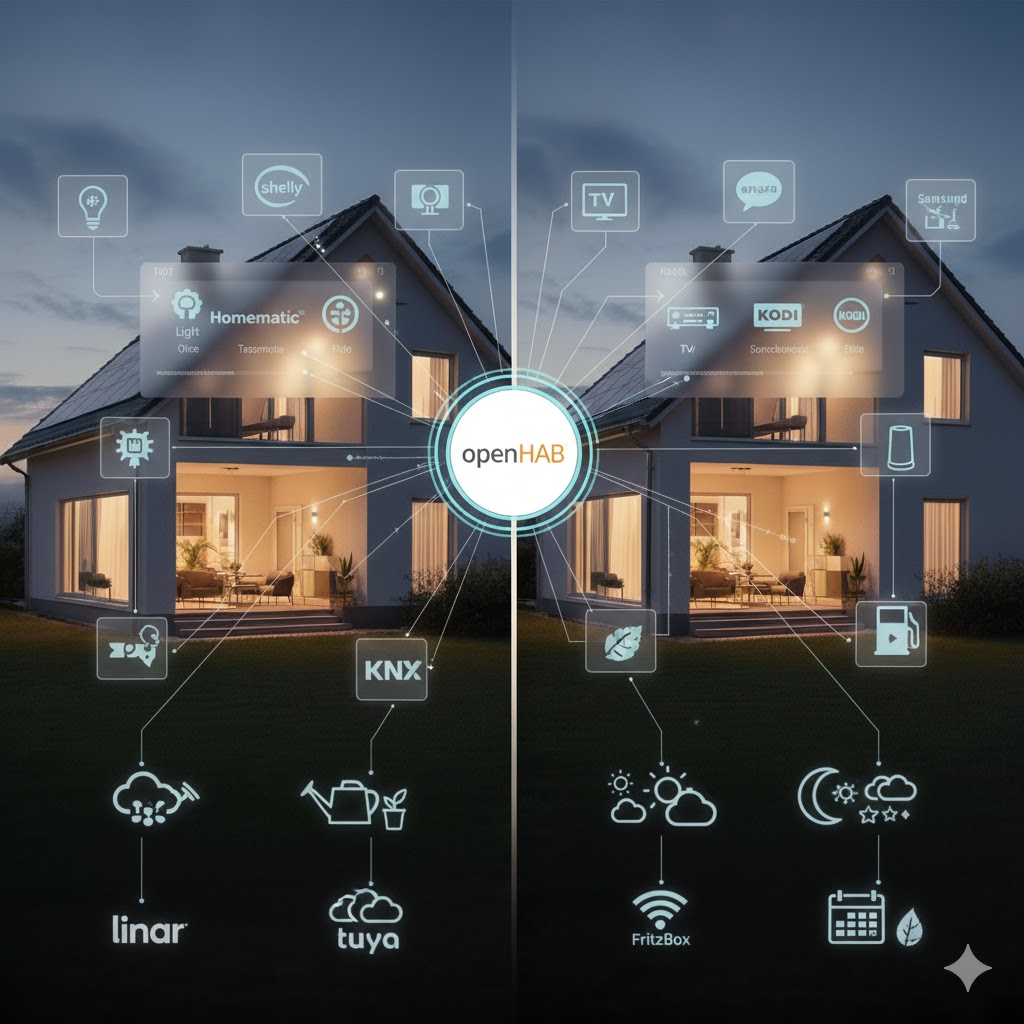

- Separates WLAN (VLAN) für Smart Home: Richte, wenn möglich, ein separates WLAN-Netzwerk (Virtual Local Area Network) für deine Smart-Home-Geräte ein. So können sie nicht direkt mit deinen anderen Geräten (Computer, Smartphone) im Hauptnetzwerk kommunizieren.

- Geräte bewusst auswählen: Informiere dich vor dem Kauf über den Hersteller und dessen Datenschutzrichtlinien. Renommierte Marken sind oft transparenter und bieten bessere Sicherheitsstandards.

- Zwei-Faktor-Authentifizierung (2FA) nutzen: Aktiviere 2FA für alle Konten, die dies unterstützen. Das bietet eine zusätzliche Sicherheitsebene.

- Nicht benötigte Funktionen deaktivieren: Schalte Mikrofone, Kameras oder Standortdienste ab, wenn du sie nicht aktiv nutzt.

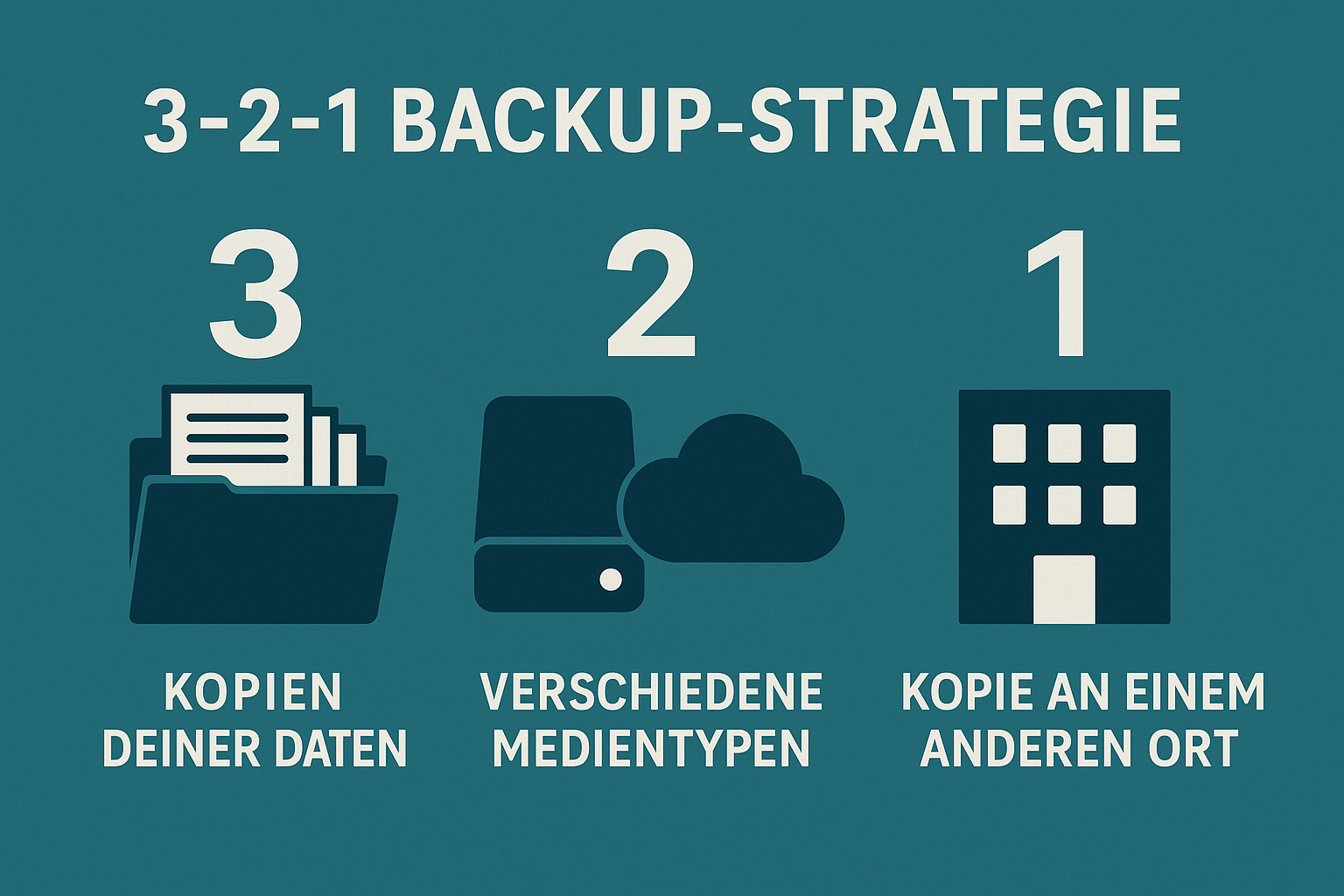

- Cloud-Speicherung überdenken: Überlege, welche Daten du unbedingt in der Cloud speichern möchtest. Viele Geräte bieten auch lokale Speichermöglichkeiten.

- Verschlüsselung aktivieren: Stelle sicher, dass die Datenübertragung zwischen deinen Geräten und der Cloud verschlüsselt ist (z.B. durch HTTPS).

Fazit

Dein Smart Home soll dein Leben bereichern, nicht deine Privatsphäre gefährden. Mit einem bewussten Umgang und der Beachtung einiger grundlegender Sicherheitspraktiken kannst du die Vorteile der vernetzten Technik genießen,